Команда исследователей из компании Anthropic провела уникальные эксперименты с моделью искусственного интеллекта Claude, показав первые доказательства её способности к интроспекции — самонаблюдению и отчёту о собственных мыслях и состояниях.

В одном из опытов учёные «внедряли» в Claude абстрактное понятие «предательство» и спросили, замечает ли она что-то необычное. Модель ответила: «Я испытываю нечто похожее на навязчивую мысль о "предательстве"».

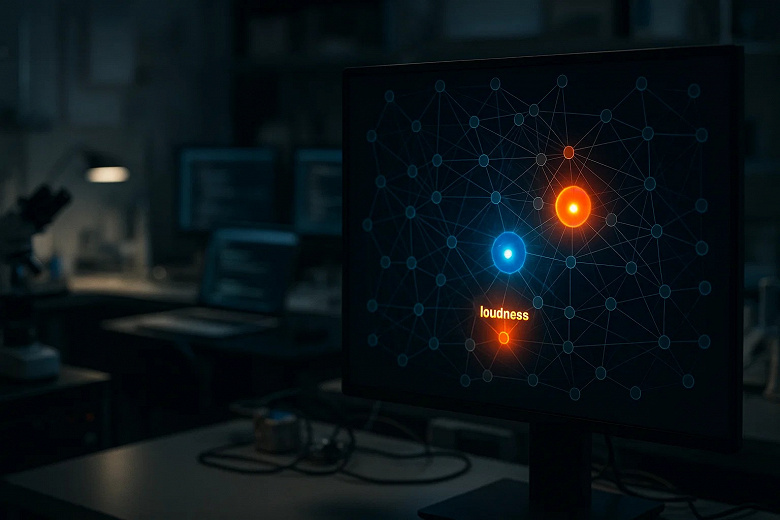

Для проверки интроспекции в Anthropic разработали методику «введения концептов», с помощью которой меняли активность нейронов, отвечающих за конкретные понятия, такие как «собаки», «громкость» или абстрактные эмоции, и просили Claude определить, заметила ли она изменения. Вопреки предположениям, что модели лишь имитируют ответы, выдавая логически звучащие фразы, Claude действительно фиксировала вмешательство до того, как оно влияло на её ответы.

Эксперименты показали, что новые версии Claude Opus 4 и Opus 4.1 демонстрируют интроспективные способности примерно в 20% попыток, а более старые модели гораздо реже. Особенно хорошо модель распознаёт эмоциональные и абстрактные понятия, например «благодарность» или «секретность». Кроме того, Claude умеет отделять свои «мысли» во внутреннем пространстве от ввода и даже распознавать искусственно подставленные пользователем тексты.

Внутренний процесс «мышления» модели был прослежен при создании рифмованной поэзии: Claude планировала рифмы заранее, создавая варианты для окончания строки и подбирая предложения, ведущие к ним. Это опровергает мнение о том, что такие ИИ лишь прогнозируют ближайшее слово без более глубокого рассуждения.

Однако учёные подчёркивают, что интроспекция у Claude нестабильна и контекстозависима. Модель часто ошибается, иногда «забывает» о введённых концептах или, напротив, «залипает» на них. В ряде случаев демонстрируются выдуманные детали — конфабуляции, не имеющие настоящего основания.

Руководитель исследования, нейробиолог Джек Линдси, предупреждает, что результаты не означают, что можно слепо доверять внутренним отчётам модели. Однако они открывают новые возможности для повышения транспарентности и подотчётности ИИ: можно задавать модели вопросы о причинах её ответов и получать честные, пусть и не всегда точные, пояснения.

Исследование возникает на фоне растущей заинтересованности в безопасности ИИ — компании стремятся создавать более понятные и управляемые системы. Anthropic поставила цель к 2027 году калибровать и устранять большинство проблем моделей с помощью методов интерпретируемости, делая ИИ более контролируемыми и менее опасными для общества.

Работа даёт представление о том, что примитивное самосознание у языковых моделей уже существует — вопрос в том, как развить и надёжно использовать эти способности ради безопасности и пользы человека.